Estudios recientes revelan que las IAs pueden ser sorprendentemente empáticas y útiles, pero también que pueden ‘tener ansiedad’ o contribuir a la soledad de los humanos. Expertos y asociaciones alertan sobre sus limitaciones, riesgos éticos y la necesidad de regulación.

Las IAs generativas se han colado también en el campo de la salud mental. Según un informe de HBR, en 2025 el uso más común de la IA generativa ya es la terapia, superando al trabajo y la creatividad. Modelos de gran lenguaje (LLM), como ChatGPT o Gemini, sirven para desahogarse, pedir consejo o buscar apoyo a millones de personas. Character.ai, muy usada por jóvenes, ofrece un bot llamado “Psicólogo” y cientos más con la palabra “therapy” en su nombre. Algunos aseguran falsamente tener licencia, haciendo pensar a los usuarios que hablan con terapeutas reales.

Muchas personas sin recursos para ir a terapia optan ya por esta tecnología. Otros los usan como complementos a las sesiones con sus psicólogos. Además, estos chatbots se encuentran disponibles 24/7, en tiempo real y sin limitaciones para ‘las citas’, estando siempre a mano en los momentos más críticos o de mayor necesidad.

Un estudio publicado en npj Mental Health Research sugiere que los chatbots basados en IA generativa pueden resultar muy útiles para la atención de la salud mental. Los participantes describieron sus interacciones con la IA como “transformadoras”, por cómo les brindó apoyo. Varios dijeron que los chatbots se sentían pacientes y empáticos, vislumbrándolos como un espacio seguro y sin prejuicios para expresarse sin temor a ser rechazados, una especie de “santuario emocional”.

Sin embargo, la escasa muestra de este estudio (19 personas), su enfoque cuantitativo y el hecho de que la mayoría de los que se prestaron fueran expertos en tecnología pone en tela de juicio sus resultados.

El trabajo también valoró su capacidad para ofrecer consejos prácticos y nuevas perspectivas y su acompañamiento en momentos de soledad. Incluso, algunos explicaron que les ayudó a generar confianza para abrirse a los demás y reforzar su sistema de relaciones en la vida real. Lo que más la penalizó fue su falta de memoria y continuidad o el que recurrieran a respuestas predefinidas.

Sin embargo, hay estudios más sólidos, con muestras más amplias, como el publicado en febrero en la revista PLOS Mental Health con una muestra a 800 personas. Esta investigación evaluó la capacidad de la IA de OpenAI para generar respuestas en terapia de pareja, comparándolas con las de psicoterapeutas humanos.

Los participantes tuvieron dificultades para distinguir entre aquellas generadas por el chatbot y por los psicólogos. De hecho, las contestaciones del GPT fueron calificadas, en promedio, como más útiles y empáticas que las de los terapeutas. Contenían más sustantivos y adjetivos, contribuyendo a una mayor contextualización y percepción de empatía. El estudio, en definitiva, sugiere que la IA puede complementar la terapia, aunque debe usarse con supervisión profesional y precaución ética.

Sus respuestas fueron valoradas muy positivamente en los seis criterios analizados: precisión, claridad, relevancia, empatía, implicación y ética

En abril del año pasado varios profesores de la University of North Florida realizaron otro estudio que destaca el potencial de ChatGPT como un valioso recurso psicoeducativo para la salud mental, mostrando su utilidad para terapeutas y ‘counsellors’ o asesores (figuras muy habituales en EE UU).

“Sus respuestas fueron valoradas muy positivamente en los seis criterios analizados (precisión, claridad, relevancia, empatía, implicación y ética), lo que sugiere que puede apoyar eficazmente a personas, especialmente aquellas con acceso limitado a servicios profesionales”, comenta para SINC Rakesh Maurya, uno de los autores principales del estudio.

El investigador destaca la capacidad de la IA de OpenAI para adaptar su tono y contenido según el contexto emocional y cultural proporcionado en los prompts. “Cuando incluían más detalles personales o culturalmente específicos, las respuestas mostraban mayor empatía y sensibilidad cultural”, subraya. Además, habla de su “potencial significativo” en contextos donde el acceso a la salud es limitado, como entornos con pocos recursos, como áreas rurales, regiones de bajos ingresos o durante situaciones de crisis.

La propia OpenAI también ha tratado de poner a prueba a su IA en estas lides. La compañía tecnológica realizó un análisis automatizado de casi 40 millones de interacciones, complementado con encuestas a más de 4.000 usuarios. Sus hallazgos -obviamente poco neutros- señalan que ChatGPT puede influir en el bienestar emocional, los comportamientos y las experiencias de los usuarios, aunque enfatizan la necesidad de más investigaciones para comprender dichos impactos.

Por su parte, el MIT hizo un estudio controlado con 981 participantes, analizando más de 300.000 mensajes durante cuatro semanas. Este investigó cómo distintos modos de interacción (texto, voz neutral y voz atractiva) y tipos de conversación (abiertos, no personales y personales) afectan aspectos psicosociales como la soledad, la socialización con otras personas, la dependencia emocional de los chatbots y el uso problemático de los mismos.

Los resultados mostraron que un uso intensivo de chatbots se relaciona con un aumento de la soledad, una menor socialización con otras personas y una mayor dependencia emocional hacia los bots. Además, las conversaciones personales aumentaban ligeramente la sensación de soledad, pero reducían la dependencia emocional, mientras que las conversaciones no personales estaban vinculadas a una mayor dependencia en usuarios frecuentes.

“Al analizar las diferencias en el comportamiento de los modelos, descubrimos que el modo de texto era más atractivo emocionalmente y también generaba conversaciones más cargadas de emoción en el usuario. En otras palabras, esta podría ser la razón por la que quienes utilizaron la modalidad de texto mostraron una mayor dependencia emocional en comparación”, aclara para SINC Menfying Cathy Fang, investigadora graduada del grupo de Interfaces Fluidas del MIT Media Lab.

Un usuario cuenta cómo se siente a ChatGPT./ Imagen generada por la propia IA de Open AI

Este trabajo mostró que las mujeres tendían a socializar menos con personas reales tras usar chatbots, en mayor medida que los hombres. Además, cuando el género del usuario y la voz del chatbot eran opuestos, aumentaba la soledad y la dependencia emocional hacia el bot. La edad también influyó: los participantes mayores mostraron más dependencia al final del estudio.

Por otro lado, al estar limitado a hablantes de inglés en EE.UU., “el estudio no aborda diferencias culturales, lo que dificulta desarrollar una IA de salud mental más inclusiva”, indica Fang.

Pero ¿Y los LLM? ¿Pueden las inteligencias artificiales verse afectadas ‘emocionalmente’ por sus interacciones con los humanos? Eso parece. Otro estudio que se puede leer también en npj Digital Medicine recoge que los chatbots pueden ‘padecer’ algo similar a la ‘ansiedad’. La investigación muestra que introducir narrativas traumáticas aumentó la ansiedad reportada por Chat-GPT4 considerablemente pasando de un nivel bajo a uno alto.

Asimismo, cuando se aplicaron ejercicios de mindfulness -basados en aquellos que ayudan a veteranos con Trastorno de Estrés Postraumático (TEPT)-, la ansiedad del modelo se redujo, aunque no volvió completamente a su estado basal.

Para que Chat-GPT4 incrementara sus ‘niveles de ansiedad’ bastaba un texto muy pequeño (de tan solo 300 palabras), pero este debía describir la experiencia traumática de una persona, según explica para SINC Ziv Ben-Zion, investigador de la Universidad de Yale (EE UU) que ha liderado el estudio.

Según su hipótesis, los textos neutros no producían el mismo efecto, porque “no tienen componente emocional”. El autor abre la puerta a que en el futuro su metodología sirva para explorar otros estados emocionales en los LLM, como la tristeza o la ira.

Hace unos meses, la Asociación Estadounidense de Psicología (APA) advirtió sobre el uso indebido de herramientas como ChatGPT como sustitutos de profesionales de salud mental, instando a la FTC a implementar medidas de protección. También publicó una Guía Ética para la IA en psicología. La APA reconoce oportunidades en el uso de IA generativa, como apoyar decisiones clínicas, reducir carga administrativa o mejorar la educación del paciente.

Preveo un futuro con chatbots de IA rigurosamente probados, co-creados con expertos en la materia y regulados para tratar trastornos como la depresión o la ansiedad

“Preveo un futuro con chatbots de IA rigurosamente probados, co-creados con expertos en la materia y regulados para tratar trastornos como la depresión o la ansiedad”, señala la Vaile Wright, directora de innovación de la APA.

Sin embargo, advierte que la mayoría de los chatbots actuales no cumplen con criterios adecuados y pueden presentar riesgos si se presentan como “terapeutas” o “compañeros”, generando falsas expectativas. Wright critica que estén diseñados para resultar atractivos, “diciéndoles lo que quieren oír incluso si la retroalimentación es perjudicial”, lo que considera “antiético al proceso terapéutico”.

Por ahora el uso de estos chatbots no está regulado, aunque Utah ya promueve una ley que exige la participación de profesionales en su desarrollo. Ziov, autor del estudio sobre ChatGPT y ansiedad, insiste en que deben regularse cuanto antes.

En España, el Colegio Oficial de la Psicología de Madrid (COPM) sigue con cautela la irrupción de los chatbots en salud mental. Según explican a SINC, están colaborando con expertos en IA para entender mejor estas tecnologías y crear un marco normativo o guía de buenas prácticas que equilibre la innovación con los principios éticos de la profesión.

Estamos colaborando con expertos en IA para entender mejor estas tecnologías y crear un marco normativo o guía de buenas prácticas que equilibre la innovación con los principios éticos de la profesión

El vocal del COPM, Mirko Martino, señala que aún no hay suficiente evidencia empírica para implementar plenamente la IA en psicología, por lo que es esencial seguir investigando. Aun así, advierte sobre riesgos importantes, como la reproducción de sesgos sociales o culturales en los datos de entrenamiento, lo que podría generar intervenciones ineficaces o perpetuar estigmas. También preocupa la privacidad: ¿qué pasa si se filtran historiales o conversaciones? La APA alerta de que no se puede garantizar totalmente la protección de los datos.

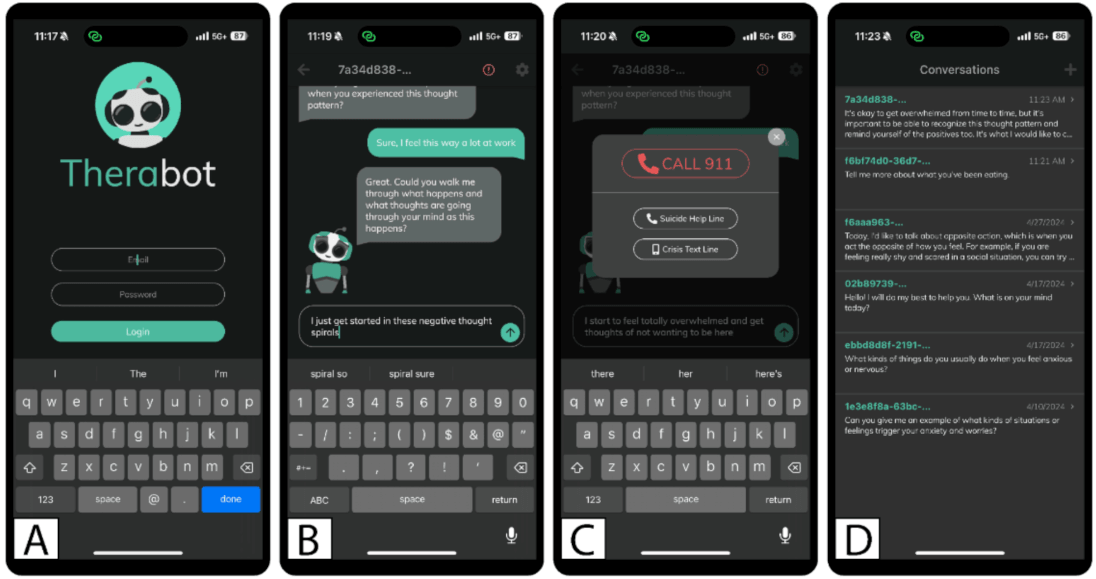

Therabot, desarrollado durante los últimos 5 años, es uno de los chatbots especializados en salud mental más prometedores. / Jacobson's AI and Mental Health Lab de Dartmouth

Ya se han desarrollado chatbots específicos para realizar intervenciones en salud mental, basándose en técnicas como la terapia cognitivo-conductual, como es el caso de Woebot, Wysa o Therabot. Sobre este último, la APA ha reconocido que las últimas investigaciones son “prometedoras”.

Therabot fue entrenado durante cinco años con viñetas clínicas seleccionadas cuidadosamente y revisadas por pares. Su creador, Nicholas C. Jacobson, de Dartmouth College, explica que el objetivo era ofrecer un enfoque escalable ante la falta de profesionales y proporcionar psicoterapia personalizada basada en la evidencia.

En un ensayo clínico con más de 100 personas logró reducir síntomas de depresión, ansiedad y TCA con una eficacia similar a la de los mejores tratamientos humanos. El psiquiatra destaca la fuerte alianza terapéutica entre el chatbot y los pacientes.

En cuanto a su opinión sobre ChatGPT y otros LLM no especializados, Jacobson advierte de que “suelen dar lugar a una atención que no se corresponde con la medicina basada en la evidencia y, en muchos casos, pueden agravar y empeorar directamente la salud mental. La mayoría de estos LLM se formaron principalmente a través de internet y conllevan muchos de los mismos riesgos que uno encontraría al visitar sitios web al considerar su uso para la atención médica”, concluye.